你有没有想过,为什么现在AI这么火,而GPU成了它的最佳拍档呢?想象GPU就像是AI的超级助手,帮它快速处理海量的数据,让AI的智慧飞速成长。那么,怎么让这个超级助手——GPU,更好地为AI服务呢?让我们一起探索吧!

一、GPU的“超能力”揭秘

首先,得知道GPU为什么这么厉害。GPU,全称是图形处理单元,它原本是给电脑游戏和视频处理用的。但是,它有个超能力——并行计算。简单来说,就是GPU可以同时处理很多任务,就像一个超级工厂,同时生产多个产品。

与CPU相比,GPU有更多的核心,这些核心就像工厂里的工人,分工合作,一起完成复杂的任务。比如,在训练AI模型时,GPU可以同时进行大量的矩阵运算和张量操作,大大提高了计算效率。

二、深度学习框架的“魔法棒”

你知道吗?为了让GPU更好地为AI服务,深度学习框架可是下了不少功夫。比如TensorFlow和PyTorch,这些框架都针对GPU进行了优化,就像给GPU戴上了一根魔法棒。

有了这根魔法棒,GPU就能更好地理解AI的需求,比如在训练过程中,GPU会根据任务的需要,自动调整计算资源,让AI的训练更加高效。

三、训练速度的“加速器”

使用GPU进行AI模型训练,就像给汽车装上了加速器,可以让AI的训练速度飞快。想象以前需要几个月的训练,现在可能只需要几天,甚至几个小时就能完成。

这是因为GPU的并行计算能力,可以让AI的训练过程更加高效。而且,GPU还可以通过多GPU配置或使用数据并行技术,处理更大的数据集,让AI的训练更加全面。

四、大规模数据处理的“得力助手”

在AI的世界里,数据就是一切。而GPU在处理大规模数据集方面,可是得力助手。无论是图像处理、语音识别还是自然语言处理,GPU都能轻松应对。

虽然GPU的内存相对较小,但通过多GPU配置或数据并行技术,就能有效解决这个问题。这样一来,GPU就能更好地处理大规模数据集,让AI的训练更加深入。

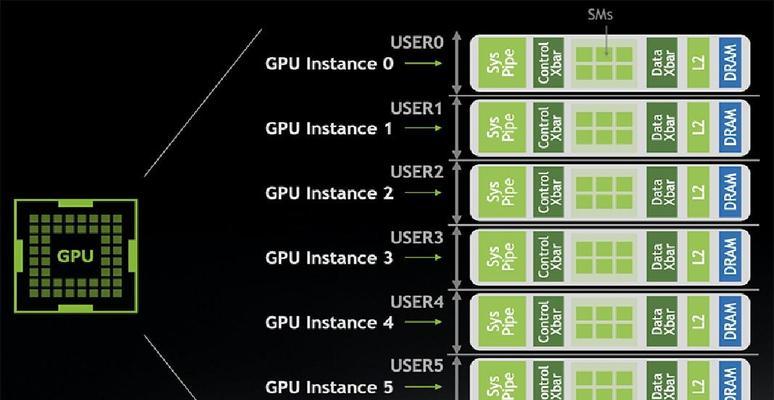

五、GPU池化AI训练平台的“共享经济”

现在,很多云服务提供商都推出了GPU池化AI训练平台,就像共享经济一样,让更多的人能够享受到GPU的强大能力。

这种平台可以让你在不需要购买和维护GPU硬件的情况下,轻松地训练AI模型。而且,你还可以根据自己的需求,灵活地调整GPU资源,让AI的训练更加高效。

要让GPU跑AI,你需要:

1. 了解GPU的“超能力”,发挥其并行计算的优势;

2. 利用深度学习框架的“魔法棒”,让GPU更好地理解AI的需求;

3. 享受GPU带来的训练速度“加速器”,让AI的训练更加高效;

4. 将GPU作为大规模数据处理的“得力助手”,让AI的训练更加全面;

5. 使用GPU池化AI训练平台,共享GPU资源,让AI的训练更加经济。

这样一来,GPU就能成为AI的超级助手,让AI的智慧飞速成长。让我们一起迎接AI的精彩未来吧!